Apple ohlásil trojicu nových funkcií, ktoré majú za úlohu zisťovať sexuálne zneužívanie detí. Ide o nové bezpečnostné funkcie komunikácie v Správach, vylepšenú detekciu obsahu CSAM (Child Sexual Abuse Material) v iCloud a aktualizované informácie v službe Siri a Hľadať.

Apple vo svojom príspevku vysvetľuje ďalšie podrobnosti o svojej snahe v oblasti bezpečnosti detí. S blížiacim sa vydaním iOS 15, iPadOS 15, watchOS 8 a macOS Monterey na jeseň tohto roku spoločnosť uvádza, že v správach, fotografiách a Siri predstaví rôzne funkcie zameriavajúce sa na bezpečnosti detí.

Správy

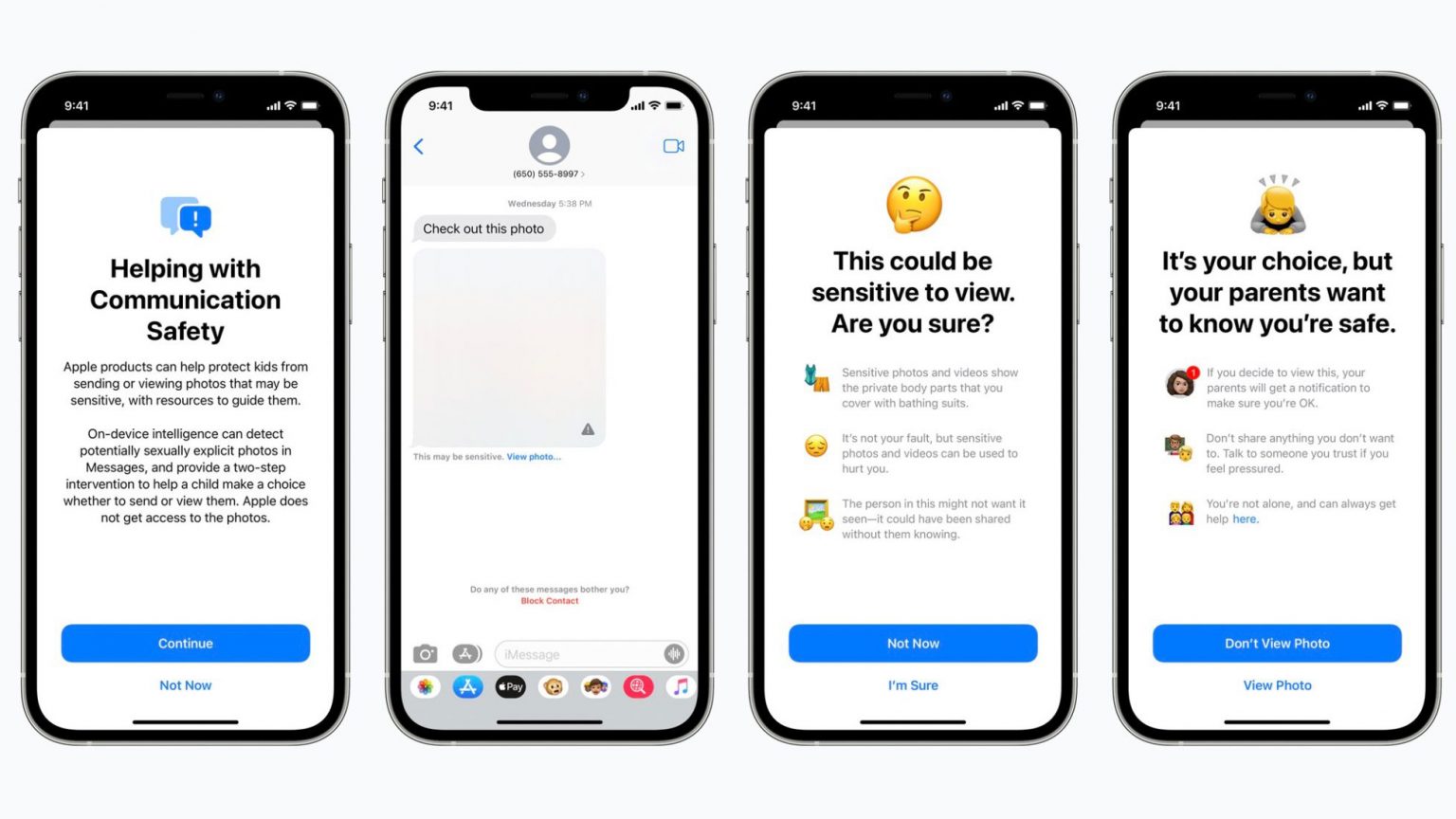

Komunikácia v službe Správy dostane bezpečnostnú nadstavbu, ktorá sa postará o to, že keď dieťa, ktoré má rodinný iCloud, dostane alebo sa pokúsi odoslať sexuálne explicitné fotografie, dieťaťu sa zobrazí varovná správa.

Apple vysvetľuje, že keď dieťa dostane sexuálne explicitnú snímku, bude rozmazaná a v aplikácii Správy sa zobrazí upozornenie, že obrázok „môže byť citlivý“. Ak dieťa klepne na položku Zobraziť fotografiu, zobrazí sa mu rozbaľovacia správa, ktorá ho informuje, prečo je obrázok považovaný za citlivý.

Funkcia príde v priebehu v tomto roku na účty nastavené ako rodinný v iCloud v aktualizáciách iOS 15, iPadOS 15 a macOS Monterey.

Detekcia CSAM

CSAM sa týka obsahu, ktorý zobrazuje sexuálne explicitné aktivity zahŕňajúce dieťa. Táto funkcia umožní Apple detekovať známe obrázky CSAM, keď sú uložené vo Fotkách na iCloude. Apple potom môže nahlásiť prípady CSAM Národnému centru pre nezvestné a zneužívané deti. Je to organizácia, ktorá funguje ako komplexná spravodajská agentúra pre CSAM a úzko spolupracuje s orgánmi činnými v trestnom konaní.

Apple zdôrazňuje, že jej metóda zisťovania CSAM je navrhnutá citlivo a s ohľadom na súkromie používateľov. Spoločnosť analyzuje obrázky výlučne v zariadení, nepostiela ich na ďalšie servery, aby zistila, či neexistujú zhody s databázou známych snímok CSAM. Všetky porovnávania sa vykonávajú na zariadení, pričom Apple transformuje databázu z Národného centra pre nezvestné a zneužívané deti na „nečitateľnú hash sadu, ktorá je bezpečne uložená v zariadeniach používateľov“.

Až keď dôjde k zhode, zariadenie vytvorí kryptografický bezpečnostný dokument, ktorý kóduje výsledok. Následne sa použije technológia nazývaná zdieľanie tajných prahov. To zaisťuje, že spoločnosť Apple nemôže interpretovať obsah bezpečnostných poukazov, pokiaľ účet iCloud Photos neprekročí prah známeho obsahu CSAM.

Siri a Hľadať

Apple zároveň rozširuje poradenstvo v oblasti Siri a Vyhľadávania poskytovaním ďalších zdrojov, ktoré pomôžu rodičom i deťom zostať v bezpečí online a získať pomoc v nebezpečných situáciách. Napríklad používatelia, ktorí sa pýtajú Siri, ako môžu nahlasovať CSAM alebo zneužívanie detí, budú poučení o zdrojoch, kde a ako podať hlásenie.

Siri a Vyhľadávanie sa aktualizujú, aby zasahovali pri vyhľadávaní dopytov súvisiacich s CSAM. Tieto intervencie vysvetlia používateľom, že záujem o túto tému je škodlivý a problematický, a poskytnú zdroje od partnerov, ktorí im pomôžu s týmto problémom.

Aktualizácie pre Siri a Hľadať prídu neskôr v tomto roku v aktualizácii pre iOS 15, iPadOS 15, watchOS 8 a macOS Monterey.